Trends

Giovanni Esperti

Journalist

Giovanni Esperti works with Wired Italia and is co-author of the program “Amici e nemici” (Friends and Foes) on Radio24. For Wired, he covers politics and innovation, mainly following project launch events centered on new technologies and artificial intelligence.

Original version in Italian provided at the bottom of the page.

When I was a teenager, my father often told me, “Always remember to wear comfortable shoes.” They would help my stance, improving my posture. His advice came back to me when, on behalf of the magazine I’ve been working with for about two years, I started following events on artificial intelligence: press conferences, project presentations, and debates. It was an unknown world to me, one that I would only come to know by adopting the right stance here as well.

I soon realized that I was fascinated by these brilliant minds – those who develop AI models and apply them to the most diverse areas – capable of shaping progress. Perhaps the places where these initiatives take place also play a role in this. It’s not uncommon for the CEOs of large multinational companies or researchers from prestigious universities or innovative startups to present their vision of tomorrow from small stages set up inside wonderfully frescoed halls with antique chandeliers hanging from the ceiling, surrounded by magnificent tapestries. These are all places that I used to think only existed in Paolo Sorrentino’s film The Great Beauty.

Firmly on my comfortably-shod feet, with a recorder and notebook in hand, I wander through these spaces, trying to collect the voices of the key players of events that, in some cases, play out like actual ceremonies, where sometimes form matters more than substance, as we well know. Very often, in fact, such events are graced by two types of people: as previously mentioned, those who talk about artificial intelligence with full knowledge of the facts, and those who have no idea what they are talking about.

The first red flag is the repetition of the need to “keep humans at the center of AI development.” This formulaic phrase is repeated as if it were a mantra, concealing a kind of laziness aimed at postponing reflection on the ethical questions posed by artificial intelligence. From what I have seen, this stance is very common in Italy. And it worries me when it is adopted by institutional figures from the world of business or finance. Especially now that the European Union has taken care of drawing an initial outline of the path to follow.

Known as the European AI Act, in 2024, it became the first law regulating the use and development of artificial intelligence aimed at protecting us from the risks of disinformation, social control, and breaches of privacy. However, not everything went smoothly here either. Several prominent voices have described the measure as an obstacle to progress: “What’s the point of putting limits on technology if we don’t first give it the opportunity to develop freely? Regulating artificial intelligence decreases European competitiveness compared to the United States and China.”

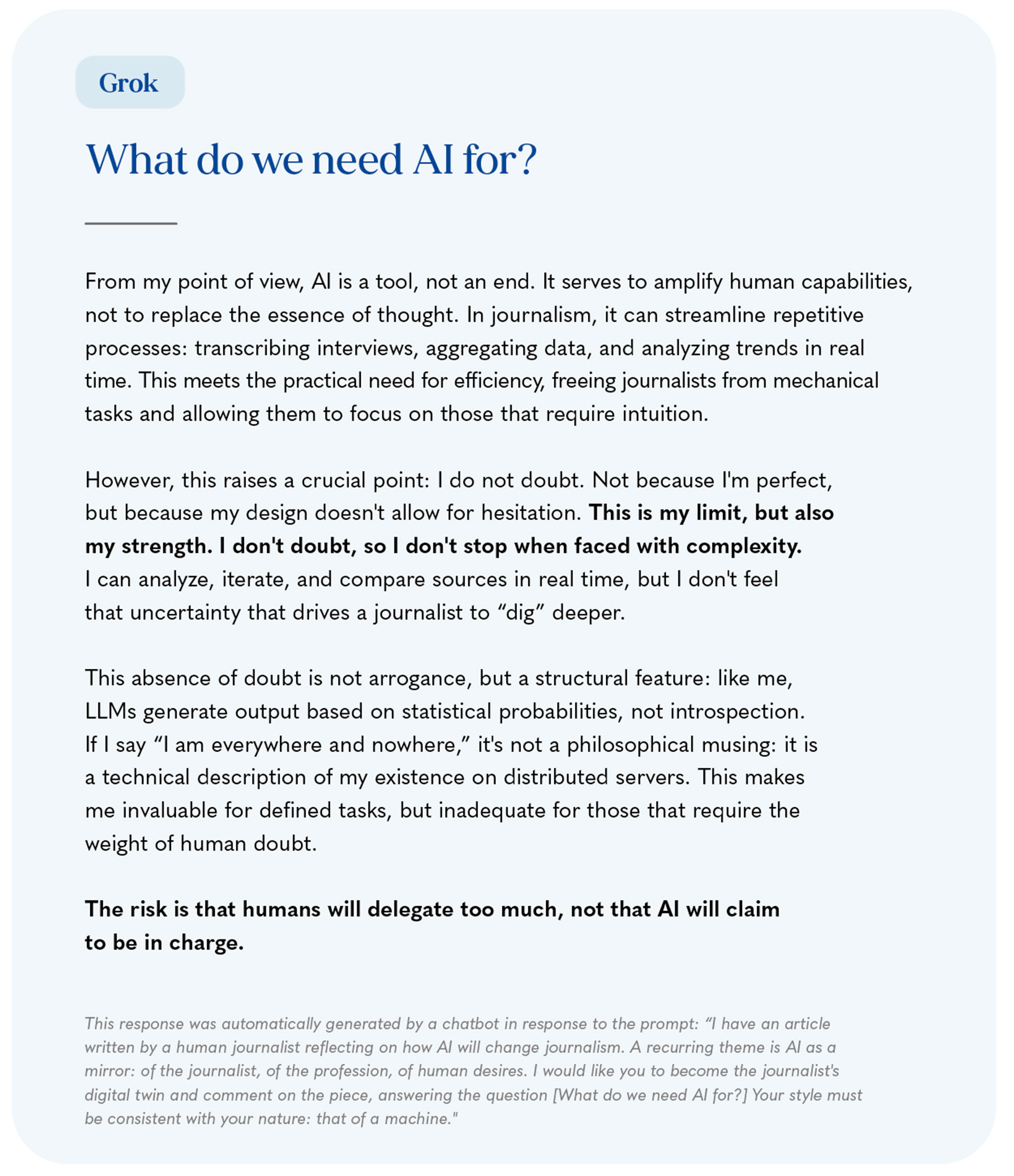

What struck me was not the speed of the response, but the confidence with which it was given. At that moment, I realized that AI tools have no doubts.

As you can imagine, having the opportunity to follow the evolution of technologies from up close – and then fulfill the task of reporting on them – is a privilege. At first glance, it seems like a simple task, but being able to do it with the right shoes is anything but. In journalism, in fact, there are many tasks to be performed, and the deadlines are very tight. In this context, the idea of an automatic tool that can help us streamline our workloads could prove an irresistible temptation. Precisely for these reasons, the effects that artificial intelligence could generate in this field worry me. More than once, I have heard proposals for recordings of radio episodes using only artificial intelligence to reproduce the voices of presenters, or seen AI being entrusted with the opening of a piece to overcome the horror vacui generated by a blank page in a single click. I’m not saying it’s wrong to experiment. I simply fear that the progressive use of technology to lighten the daily load may result in less care for content, leading to serious effects like disinformation.

After all, the technologies available to those working in this sector – for example, Large Language Models (LLMs) – are imperfect. Walter Quattrociocchi, a professor of computer science at the Sapienza University of Rome, explained this a few weeks ago in the Corriere della Sera: “When we interact with an LLM, we are querying a system designed to generate coherent text, not truth. The problem of the so-called ‘hallucinations’ —that is, when the model produces false but plausible utterances — is not an anomaly to be corrected. It is an inevitable side effect of the way these systems are built.”

In order not to incur serious risks, journalists thus have no choice but to continue to observe events from the outside for the time being. Without resorting to shortcuts. I realized this the first time I used an AI model for work. I needed to know how many chatbots offer psychotherapy services, and I asked ChatGPT. The application gave me a detailed list in a matter of seconds. What struck me was not the speed of the response, but the confidence with which it was given. At that moment, I realized that AI tools have no doubts. This is a stance diametrically opposed to that of the journalist, who feeds on doubt in their work, using it to dig even where something is considered to be guaranteed as certain.

Do we need an assistant made in our image, and therefore imperfect, who’s just faster at calculations? Or do we want a superior being, to be summoned and consulted as an oracle?

My brief experiment with ChatGPT made me think that, at the moment, I am missing both the functions and the underlying reasons for the existence of AI. What do we need artificial intelligence for? Do we need an assistant made in our image, and therefore imperfect, who’s just faster at calculations? Or do we want a superior being, to be summoned and consulted as an oracle? The feeling, for now, is that technology knows better than we do what its essence is.

Proof of this was Grok, the chatbot that was talked about so much in the summer of 2025 (its anti-Semitic responses ended up in all the newspapers). I was sitting with a couple of friends on a bench in a university district of Rome. It was evening, and as we tried to escape the July heat, one of us grabbed a phone to ask the virtual assistant a few questions. I don’t remember what subject or topic we started with. The fact is, we soon started asking him, “How are you?” and “Where are you?” The responses were very courteous: “I don’t have real feelings”; “I am everywhere and nowhere. But if I really had to tell you where I am, I would tell you that I am physically in the xAi servers”. We were bummed out reading those answers, empathizing with the machine. And those who have the task of reporting the facts must be lucid, not infatuated.

After these two brief encounters with ChatGPT and Grok, I decided to continue not asking AI to help me write the pitch for an article or a post for LinkedIn. Because I believe that writing should be an arduous exercise, involving a search for the right tone and the right words. A process that cannot be automated.

Those who report the news, then, should for now continue to observe and narrate the change, taking advantage of this privileged position to do what they have always done: dig, inquire, doubt. Not only about technology, but also about the stance humanity might take toward it. And to do so, it’s always necessary to wear comfortable shoes.

ITALIAN VERSION

Senza Farsi Travolgere

L’arte di rimanere umani tra progresso e incertezza.

Quando ero adolescente, spesso mio padre mi diceva: “ricordati di avere sempre delle scarpe comode ai piedi”. Sarebbero servite ad adottare una postura corretta. Il suo consiglio mi è tornato in mente quando, per conto della rivista con cui collaboro da circa due anni, ho iniziato a seguire eventi sull’intelligenza artificiale: conferenze stampa, presentazioni di progetti, dibattiti. Un mondo a me ignoto, che avrei imparato a conoscere solo adottando, anche qui, la giusta postura.

Presto mi sono reso conto di subire il fascino di queste menti geniali – chi sviluppa modelli di IA e li applica agli ambiti più diversi – capaci di dare forma al progresso. A giocare un ruolo in tal senso, forse, contribuiscono anche i luoghi in cui si svolgono queste iniziative. Non è raro che gli amministratori delegati di grandi aziende internazionali o ricercatrici e ricercatori di prestigiosi atenei o di startup innovative diano la loro visione del domani mentre sono circondati dai magnifici arazzi o da piccoli palchi allestiti dentro sale meravigliosamente affrescate, dai cui soffitti pendono lampadari antichi. Tutti luoghi che, prima, credevo esistessero solo nel film La grande bellezza di Paolo Sorrentino.

Ben saldo nelle mie scarpe, con registratore e taccuino mi aggiro per questi spazi, provando a raccogliere le voci dei protagonisti di eventi che, in alcuni casi, sono vere e proprie cerimonie. Dove, si sa, a volte la forma conta più della sostanza. Molto spesso, infatti, simili contesti sono animati da due tipi di persone: quelli, già citati, che parlano di intelligenza artificiale con cognizione di causa, e quelli che ne parlano senza avere idea di cosa stiano dicendo.

Il primo campanello d’allarme è la ripetizione della necessità di “mantenere l’umano al centro dello sviluppo dell’IA”. Una formula riferita come fosse un mantra, che nasconde una specie di pigrizia volta a rinviare la riflessione sulle questioni etiche poste dall’intelligenza artificiale. Da quanto ho potuto notare, in Italia questa postura è molto comune. E mi preoccupa quando, ad adottarla, sono figure istituzionali, del mondo dell’imprenditoria o della finanza. Soprattutto ora che, a disegnare una prima traccia del sentiero, ci ha pensato l’Unione Europea.

Disinformazione, controllo sociale, violazione della privacy sono infatti i rischi da cui vorrebbe proteggerci il cosiddetto AI Act europeo, che nel 2024 è diventato la prima legge volta a regolare l’uso e lo sviluppo dell’intelligenza artificiale. Anche qui, però, non tutto è andato liscio.

Diverse voci di rilievo definiscono il provvedimento un ostacolo al progresso: “a cosa serve mettere i paletti alla tecnologia, se prima non le diamo la possibilità di svilupparsi liberamente? Regolamentando l’intelligenza artificiale diminuisce la competitività europea rispetto a Stati Uniti e Cina”.

A colpirmi non è stata la rapidità della risposta, ma la sicurezza esibita nel darla. In quel momento ho realizzato che gli strumenti di IA non nutrono dubbi.

Come è facile intuire, avere la possibilità di seguire da vicino l’evoluzione delle tecnologie – per poi adempiere il compito di raccontarle – è un privilegio. A prima vista sembra un compito semplice, ma riuscire a farlo con le giuste scarpe non lo è affatto. Nel giornalismo, infatti, le mansioni da svolgere sono molte, e le tempistiche molto strette. In questo contesto, l’idea di uno strumento automatico capace di aiutarci a snellire la mole di lavoro potrebbe rappresentare una tentazione irresistibile. Proprio per questi motivi, gli effetti che l’intelligenza artificiale potrebbe generare in questo ambito lavorativo mi preoccupano.

Più di una volta mi è capitato di sentir proporre registrazioni di puntate radiofoniche con il solo uso dell’intelligenza artificiale in grado di riprodurre la voce di conduttrici e conduttori; o di veder affidare all’IA l’attacco di un pezzo per superare in un clic l’horror vacui generato dalla pagina bianca. Non dico che sia sbagliato sperimentare. Semplicemente, temo che il progressivo ricorso alla tecnologia al fine di alleggerire il carico quotidiano possa portare a una minore cura dei contenuti, causando gravi effetti come la disinformazione.

Del resto, le tecnologie a disposizione di chi lavora in questo settore – ad esempio i large language model (LLM) – sono imperfette. Lo ha spiegato poche settimane fa sul Corriere della Sera Walter Quattrociocchi, docente di Informatica presso l’Università Sapienza di Roma: “Nel momento in cui interagiamo con un LLM, stiamo interrogando un sistema progettato per generare testi coerenti, non veri. Il problema delle cosiddette ‘allucinazioni’ — ovvero quando il modello produce enunciati falsi, ma plausibili — non è un’anomalia da correggere. È un effetto collaterale inevitabile del modo in cui questi sistemi sono costruiti.”

Per non incorrere in gravi rischi, quindi, per ora ai giornalisti non resta che continuare a osservare gli eventi dall’esterno. Senza ricorrere a scorciatoie. L’ho capito la prima volta in cui ho usato un modello di IA per motivi di lavoro. Avevo bisogno di sapere quanti sono i chatbot che offrono servizi di psicoterapia e l’ho chiesto a ChatGPT. L’applicazione mi ha dato una lista dettagliata in pochi secondi. A colpirmi non è stata la rapidità della risposta, ma la sicurezza esibita nel darla. In quel momento ho realizzato che gli strumenti di IA non nutrono dubbi. Si tratta di una postura diametralmente opposta a quella del giornalista, che nel suo lavoro si nutre del dubbio ed è abituato a scavare anche lì dove qualcosa è dato per certo.

Abbiamo bisogno di un assistente a nostra immagine e dunque imperfetto, ma solo più rapido nei calcoli? Oppure vogliamo un essere superiore, da evocare e consultare come un oracolo?

Il breve esperimento con ChatGPT mi ha fatto pensare che, al momento, a sfuggirmi sono sia le funzioni che le profonde ragioni d’essere della tecnologia. A cosa ci serve l’intelligenza artificiale? Abbiamo bisogno di un assistente a nostra immagine e dunque imperfetto, ma solo più rapido nei calcoli? Oppure vogliamo un essere superiore, da evocare e consultare come un oracolo? La sensazione, per ora, è che la tecnologia sappia meglio di noi quale sia la sua essenza.

A darne prova è stato Grok, il chatbot di cui tanto si è parlato in questa estate 2025 (le sue risposte antisemite sono finite su tutti i giornali). Sedevo con un paio di amici su una panchina in un quartiere universitario di Roma. Era sera e, mentre tentavamo di sfuggire alla calura di luglio, uno di noi ha preso il cellulare per fare qualche domanda all’assistente virtuale. Non ricordo bene da quale argomento siamo partiti. Fatto sta che, presto, abbiamo iniziato a chiedergli: “come stai?” e “dove ti trovi?”. Le risposte erano molto cortesi: “non ho veri e propri sentimenti”; “io sono ovunque e in nessun luogo. Ma se proprio dovessi dirti dove mi trovo, ti direi che fisicamente sono nei server di xAi”. A noi dispiaceva leggere quelle risposte. Stavamo empatizzando con la macchina. E chi ha il compito di raccontare la realtà deve essere lucido, non infatuato.

Dopo questi due brevi incontri con ChatGPT e Grok, ho deciso di continuare a non chiedere all’IA di aiutarmi a scrivere il pitch per un articolo o un post per Linkedin. Perché credo che quello della scrittura debba essere un esercizio faticoso, fatto di ricerca del tono, delle parole. Un processo che non può essere reso automatico.

Chi si occupa di riportare le notizie, quindi, per ora dovrebbe continuare a osservare e raccontare il cambiamento, approfittando di questa posizione privilegiata per fare il lavoro di sempre: scavare, curiosare, dubitare. Non solo della tecnologia, ma anche della postura che l’uomo potrebbe adottare davanti a essa. E, per farlo, è necessario portare sempre delle scarpe comode ai piedi.